大模型概述

随着时代的发展,大模型各个领域的应用正在不断扩大。本文尽力梳理各种材料,将从概念定义,类型分类,训练以及应用等方面对大模型进行一个简要的概述。

如果你想了解大模型但是却缺乏基础的知识或者觉得无从下手,那么阅读该文章可能对你有所帮助。

概念定义

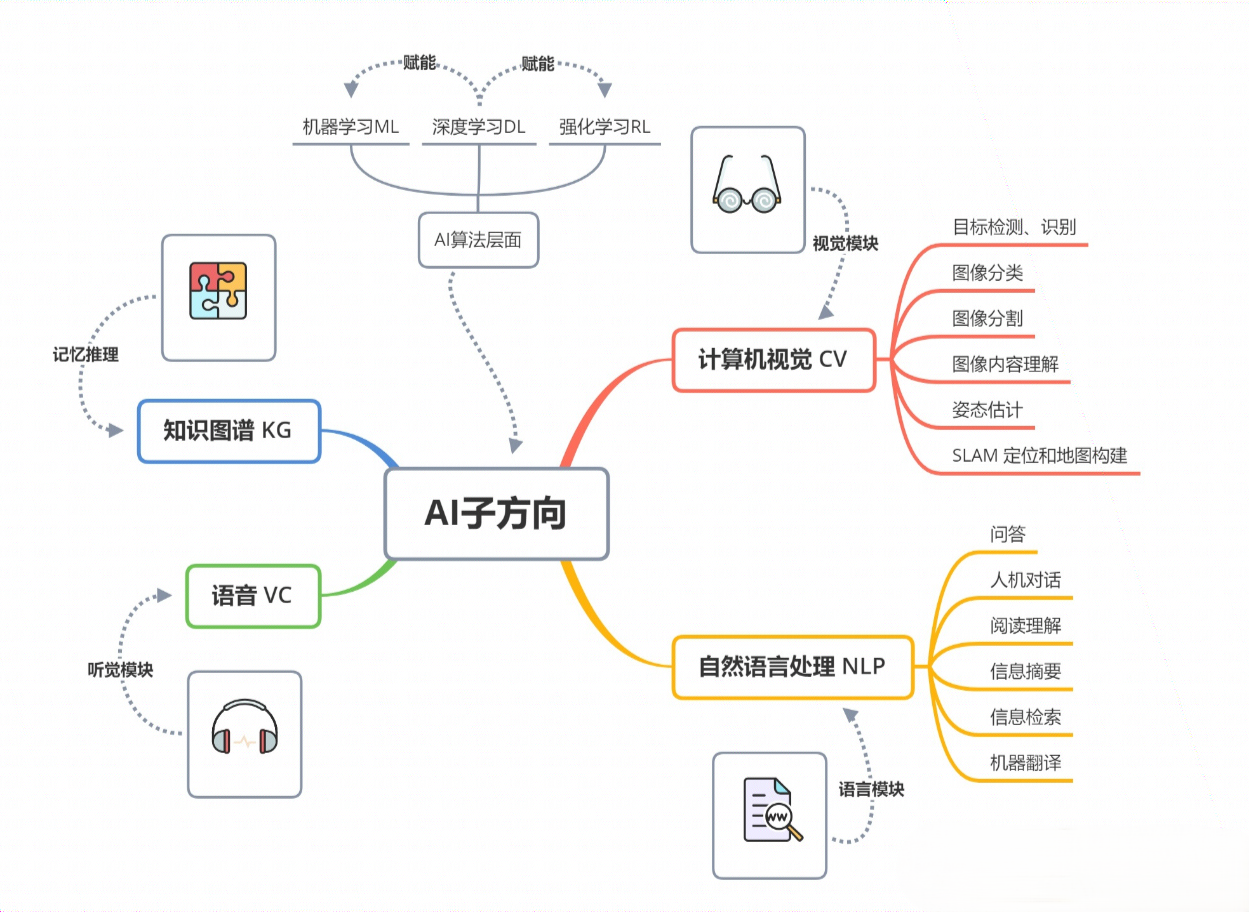

人工智能主要概念

应用领域

算法

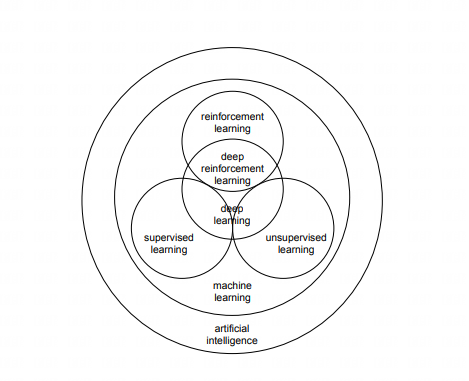

机器学习 ( Machine Learning ) 是 AI 的一个核心子领域,它让机器可以通过数据来学习和预测。

- 监督学习:学习带标签的数据,并预测未见数据的标签。

- 线性回归 ( Linear Regression ) 。

- 支持向量机 ( Support Vector Machines ) 。

- 决策树 ( Decision Trees ) 。

- 随机森林 ( Random Forest ) 。

- 无监督学习:处理不带标签的数据,常用于聚类和降维。

- K 均值 ( K-Means ) 。

- 层次聚类 ( Hierarchical Clustering ) 。

- 主成分分析 ( PCA ) 。

- 强化学习:智能体通过与环境互动并接收奖励或惩罚来学习。

- Q-learning。

- Deep Q Networks ( DQN ) 。

- Actor-Critic 方法。

- Proximal Policy Optimization ( PPO ) 。

- 深度学习:主要使用神经网络,尤其是深层网络。

- 卷积神经网络 ( CNN ) 。

- 循环神经网络 ( RNN ) 。

- 长短时记忆网络 ( LSTM ) 。

- Transformer 结构 ( 如 BERT, GPT 等 ) 。

大模型的定义

"大模型"这个概念比较难定义,到目前为止没有广泛接受的,官方的定义。其对应的英文单词为:foundation model,也称为:general-purpose AI 或 GPAI。指可以执行一系列的常规任务,例如文本合成,图像处理以及音频合成等的模型。以下是一些论文或机构官网给出的定义:

On the Opportunities and Risks of Foundation Models ( 2021 )

2021 年 8 月份,斯坦福大学教授李飞飞和 100 多位学者联名发表一份 200 多页的研究报告《On the Opportunities and Risk of Foundation Models》,深度地综述了当前大规模预训练模型面临的机遇和挑战。

AI is undergoing a paradigm shift with the rise of models ( e.g., BERT, DALL-E, GPT-3 ) that are trained on broad data at scale and are adaptable to a wide range of downstream tasks. We call these models foundation models to underscore their critically central yet incomplete character.

随着模型 ( 例如 BERT, DALL-E, GPT-3 ) 的兴起,人工智能正在经历范式转变,这些模型在大规模上对广泛的数据进行训练,并适应广泛的下游任务。我们称这些模型为基础模型,以强调其关键的核心但不完整的特征。

Foundation models are AI neural networks trained on massive unlabeled datasets to handle a wide variety of jobs from translating text to analyzing medical images.

基础模型是在大量未标记数据集上训练的 AI 神经网络,用于处理从翻译文本到分析医学图像的各种工作。

- 大模型的 5 个关键特征。

- 预训练。使用大数据和大规模计算,以便无需任何额外训练即可使用。

- 通用。一个模型可以用于许多任务。

- 适应性强。使用叙述文本作为模型输入。

- 大。例如 GPT-3 有 1750 亿个参数。但是随着参数的不断增长,这个标准也在不断提高。

- 自我监督。无提供特定标签。

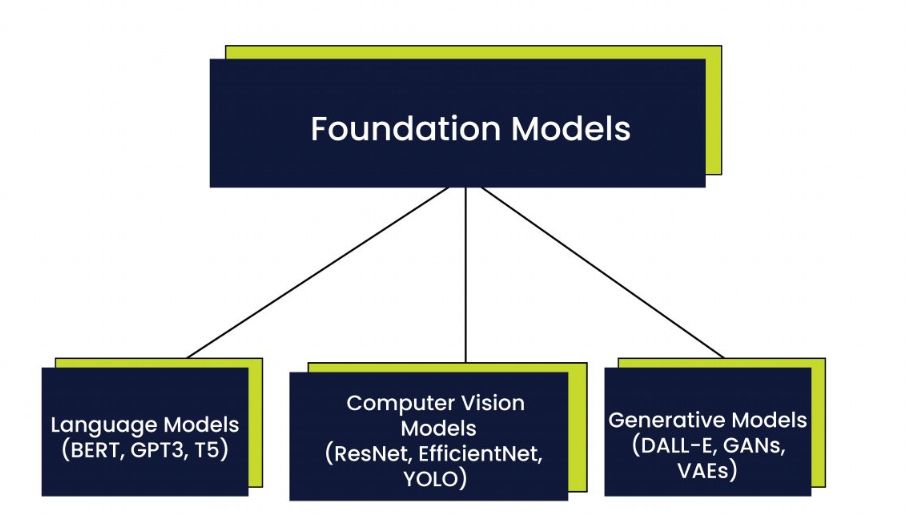

大模型的类型

大模型大致可分为三种类型:语言模型、计算机视觉模型和生成模型。[2]

语言模型

- BERT

由 Google 开发的 BERT 是一种预先训练的语言模型,能够理解自然语言文本的细微差别。根据谷歌的说法,BERT 在各种自然语言处理任务 ( 包括问答,翻译,情感分析和预测文本 ) 上优于以前基于递归神经网络 ( RNN ) 的语言模型。

- GPT3

由 OpenAI 开发的 GPT-3 是一个更大的语言模型,已经在一个非常大的数据集上进行了训练。GPT-3 拥有 1750 亿个参数,可以生成与人类编写的文本无法区分的文本。该模型已用于各种应用,包括聊天机器人和虚拟助手。

T5

T5 是 Google 开发的最新语言模型,它采用不同的自然语言处理方法。T5 不是针对 BERT 等特定任务进行微调,而是一种通用语言模型。经过训练以执行广泛的任务,包括文本分类、问答和摘要等。T5 使用统一的文本到文本格式,这使其能够轻松适应各种自然语言处理任务。

视觉模型

- ResNet

由 Microsoft 开发的 ResNet 是一个深度神经网络,能够以极高的精度对图像进行分类。该模型已用于各种应用,包括自动驾驶汽车的图像识别。

EfficientNet

由 Google 开发的 EfficientNet 是另一种计算机视觉模型,在各种图像分类任务上取得了最先进的结果。该模型以其效率而著称,与其他领先的计算机视觉模型相比,所需的参数要少得多。

YOLO

YOLO 是一种实时物体检测系统,能够以非常高的精度检测图像中的物体。该模型已用于各种应用,包括自动驾驶汽车和安全系统。

生成模型

DALL-E

由 OpenAI 开发的 DALL-E 是一种生成模型,能够从自然语言提示创建图像。该模型引起了艺术界的极大兴趣,因为它能够生成高度逼真和富有想象力的图像。

GANs

由 Ian Goodfellow 开发的生成对抗网络 GAN 是一种生成模型,能够通过使两个神经网络相互对抗来生成新数据。谷歌的 BigGAN 就是这种模型的一个例子,它在一个巨大的图像数据集上进行了训练,使其能够创造出具有令人难以置信的细节和真实感的生成艺术。BigGAN 已广泛用于广告、营销,甚至用于生成虚拟视频游戏环境。

VAEs

VAEs 是一种生成模型,能够通过学习数据集的底层结构来生成新数据。这些模型已用于降维和异常检测等应用。

关于训练 [3]

通用步骤

收集数据集。

基础模型需要在非常大的数据集 ( 例如文本或代码 ) 上进行训练。数据集应尽可能多样化,并且应涵盖您希望模型能够执行的任务。

准备数据集。

需要先准备数据集,然后才能用于训练模型。这包括清理数据、删除任何错误以及以模型可以理解的方式设置数据的格式。

打标记。

标记化是将文本分解为单个标记的过程。这对于基础模型是必需的,因为它们需要能够理解文本中的各个单词和短语。

配置训练过程。

配置训练过程以指定超参数、训练算法体系结构和将使用的计算资源。

训练模型。

将使用指定的训练模型体系结构在数据集上训练模型。这可能需要很长时间,具体取决于模型的大小和数据量。

评估模型。

训练模型后,您需要在保留数据集上评估其性能。这将帮助您确定模型是否按预期执行。

部署模型。

对模型的性能感到满意后,可以将其部署到生产环境。这意味着使模型可供用户使用,以便他们可以使用它来执行任务。

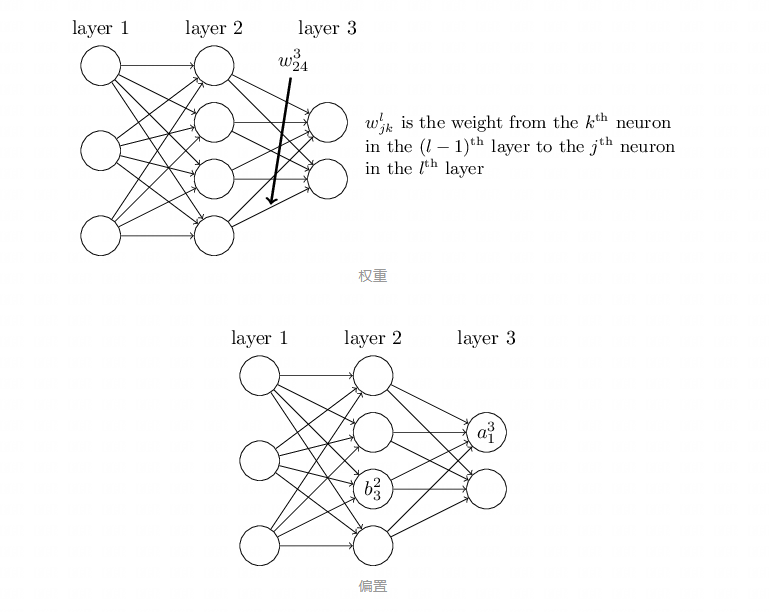

什么是迭代?

一次迭代一般包含以下三个步骤:

向前传播 ( forward ) 。

简单理解就是将上一层的输出作为下一层的输入,并计算下一层的输出,一直到运算到输出层为止。

向前传播 用矩阵来表示:

z(l)=W(l)a(l−1)+b(l)

a(l)=σ(z(l))

其中 σ 为激活函数,如 Sigmoid, ReLU, PReLU 等。

计算损失。

模型输出完成后,接下来就是要评估模型的表现。这是通过计算损失函数 ( Loss Function ) 来实现的。损失函数量化了模型预测和真实标签之间的差距。常见的损失函括交叉熵损失 ( 用于分类问题 ) 和均方误差 ( 用于回归问题 ) 。

损失函数的计算通常表示为:Loss=f(ModelOutput,TrueLabel)。

反向传播 ( backward ) 。

计算出损失之后,接下来的任务是更新模型的参数以便减少这个损失。反向传播是一种高效计算损失函数关于每个参数梯度的方法。

计算梯度:从输出层开始,计算损失函数关于各层参数的偏导数 ( 梯度 ) 。

更新参数:用这些计算出的梯度来更新模型参数。参数的更新通常使用优化算法 ( 如梯度下降 ) 。

NewParameter=OldParameter−α×Gradient

训练算法的目标 [4]

利用海量的数据 ( Leveraging broad data )

当前网络上产生的海量数据,以多种形式出现。包括文本,图像,录音,视频和机器人传感器。由于这些数据缺乏额外的标注,所以当前研究都集中在设计自我监督的算法,利用每种类型的独特结构的数据产生基础模型的训练信号。

领域完备性 ( Domain completeness )

大模型需要解决的一个重要目标就是需要对领域中的下游任务具有广泛而有用的能力。这个属性对于大模型的通用性至关重要。但是哪些任务会影响领域完备性并不是显而易见的,甚至如何去评估一个模型的广泛性也是困难的。

扩展和计算效率 ( Scaling and compute efficiency )

自我监督的算法的兴起是的模型的大小和计算资源瓶颈日益凸显。训练的效率在不同的设计上可能会大有不同,因此,训练研究人员的一个主要目标是设计具有更丰富的训练信号的训练目标,从而使模型学习更快,获得更强的能力。

重要的设计选择

抽象的级别

一个基本问题是:基础模型的输入表示应该是什么?

- 一种选择是在 原始字节级别 对输入进行建模。但是,这种高维数可能会导致模型专注于预测输入的语义较少的方面,从而减慢其获得更普遍有用的功能的速度。并且在 Transformer 中其计算成本随输入大小呈二次增长。

- 另一种选择是 使用领域知识 来减少模型的输入空间——此类策略包括块向量表示 ( patch embedding ) 以及固定或学习的标记化。这些方法可能会减轻生成方法面临的一些挑战,但代价是它们可能会抛弃输入中可能有用的信息。

生成模型与判别模型

生成模型。

试图学习数据的联合概率分布 P(X,Y),其中 X 是输入特征,Y 是标签。例如:GMM, Naive Bayes, HMM, GANs。

- 自回归基础模:在生成序列 ( 如文本或音乐 ) 时,每一个元素都是基于前面所有已生成元素的函数。

- 去噪基础模:这类模型通常会先接收一个被添加噪声或以某种方式损坏的输入,然后尝试重构或生成一个"干净"的版本。

虽然生成训练方法有其优点,但一些判别方法也最近开始受到关注。

判别模型。

试图学习条件概率分布 P(Y∣X),即在给定输入 X 的情况下,输出 Y 的概率。例如:逻辑回归,支持向量机 SVM,决策树,随机森林,CNN。

通常在分类任务中表现更好,计算效率更高。但是对数据要求量更大,数据稀少时不如生成模型表现好。

更好地理解生成和判别训练之间的权衡,以及捕获两种方法的最佳之处,仍然是未来研究的有趣方向。

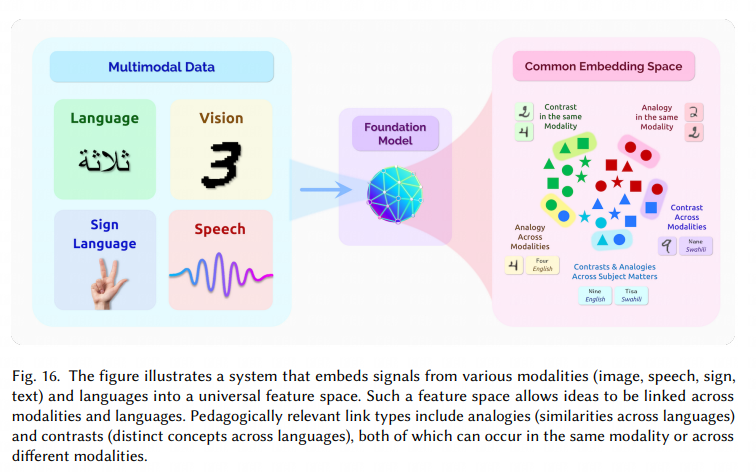

捕获多模态关系

另一个日益重要的研究领域是捕获多种类型数据之间的关系。这意味着根据情境和模型设计者的目标,具体内容可能有所不同。例如 CLIP 和 ViLBERT 都是多模态视觉-语言模型,但在多模态的具体实现方式上有所不同。前者将图像和文本分别编码为向量,使得只有单一模态样本的用户也能检索、评分或分类来自另一模态的样本。后者则在模型的早期阶段就开始联合处理图像和文本,这有助于支持诸如视觉问题回答这样的下游应用,在这些应用中,需要对一对相关的图像和文本 ( 例如,图像及其相关问题 ) 进行推理。多模态基础模型仍然是一个崭新的研究领域。关于模型可以以何种不同方式实现多模态,以及这些额外的模态能带来哪些能力,还有很多未探索的问题。

挑战

- 数据不平衡。不同模态的数据量和质量可能有很大的差异。

- 复杂性。多模态信息通常意味着更高的计算和模型复杂性。

- 语义鸿沟。不同模态之间可能存在语义鸿沟,使得捕获它们之间的内在关联变得困难。

未来的方向 [4:1]

解决特异性

目前在自然语言处理,计算机视觉和语音处理中盛行不同的方法。这有两个主要缺点:首先,这些不同的技术使得掌握这些方法中每种方法的共同线索和科学原理变得具有挑战性。其次,这种领域特异性要求为每个新领域从头开始开发新的基础模型训练方法,包括医学、科学和新的多模态设置。

获得丰富的训练信号

很明显,并非所有训练目标都是平等的——有些训练目标比其他目标效率更高,从而转化为给定计算预算下功能更强大的基础模型。是否有比目前已知的训练方法更有效的训练方法?如果是这样,我们如何找到它们?

基础模型的目标导向训练

我们能否训练基础模型,其中理解和可靠地执行复杂世界中目标的能力是模型训练目标的一部分?专注于开发一般能力将这个方向与通过强化学习使现有基础模型适应特定任务的目标区分开来。

行业应用 [4:2]

医疗和生物医学

医疗保障的机会

- 对医院

- 可以改善医院提供护理的效率和准确率。如用于诊断/治疗的自动辅助系统、患者记录摘要和患者问题的回答。

- 特别是在 COVID-19 等紧急大流行危机中,快速诊断/筛查 ( 例如,胸部 X 射线图像的自动分析 ) 以及患者和公众的自动问答 ( 例如,症状检查和护理 ) 和公众 ( 例如,疾病预防 ) 对于减少疾病传播和为危重患者分配医疗保健资源、挽救更多生命至关重要。

- 基础模型可以提高提供者护理的效率和准确性。医疗保健提供者花费不必要的时间来编辑电子健康记录 ( EHR ) 。

- 可预防的医疗错误 ( 例如,再入院、手术错误 ) 会导致医疗保健浪费。

- 对患者

- 大模型可提供门诊预约和相关信息。

- 回答患者相关问题。

- 药物的相关解答 ( 文本,图片等多模态 ) 。

- 对大型流行病等医疗问题的问答系统 ( 特别是 COVID-19 ) 。

生物医学的机会

- 基础模型可以促进生物医学研究,例如药物的发现和对疾病的理解,最终转化为改进的医疗保健解决方案。

- 基础模型具有强大的生成能力 ( 例如,GPT-3 中的连贯文本生成 ) ,这可以帮助生物医学研究中的生成任务,例如生成实验方案 ( 临床试验 ) 和根据现有数据设计有效的分子 ( 药物发现 ) 。

- 基础模型有可能整合医学中的各种数据模式,从而能够从多个尺度 ( 使用分子、患者和人口水平的数据 ) 和多个知识来源 ( 使用成像、文本和化学描述 ) 研究生物医学概念。这促进了生物医学发现,如果使用单一模态数据很难获得。

- 基础模型还支持跨模式的知识转移。Lu 等人展示了如何在自然语言 ( 一种数据丰富的模态 ) 上训练的变压器模型如何适应其他基于序列的任务,例如蛋白质折叠预测,这是生物医学中一项长期研究的预测任务。

挑战与风险

多模态。

医学数据是高度多模态的,具有各种数据类型 ( 文本、图像、视频、数据库、分子 ) 、规模 ( 分子、基因、细胞、组织、患者、人口 ) 和风格 ( 专业和非专业语言 ) 。当前的自我监督模型是针对每种模式开发的 ( 例如,文本 、图像 、基因、蛋白质 ) ,并且不会共同学习不同的模式。为了从这些不同的多模态医学数据中学习跨模态和跨模态信息,我们需要研究基础模型训练中的特征级和语义级融合策略。如果做得有效,这有可能统一生物医学知识并促进发现。

可解释性。

可解释性——为决策提供证据和逻辑步骤——在医疗保健和生物医学中至关重要,并且根据《通用数据保护条例》 ( GDPR ) 是强制性的。例如,在诊断和临床试验中,必须将患者的症状和时间相关性解释为证据。这有助于解决系统与人类专家之间潜在的分歧。医疗保健中的知情同意也需要可解释性。然而,当前基础模型的训练目标不包括可解释性,需要未来朝这个方向进行研究。合并知识图谱可能是进一步提高模型可解释性的一步。

法律和道德法规。

外推法。

生物医学发现的过程涉及外推。例如,基础模型必须能够快速适应新的实验技术 ( 例如,新的测定方法;新的成像技术,例如高分辨率显微 ) 或新的设置 ( 例如,新的目标疾病;例如 COVID-19 ) 。利用现有数据集并推断到新设置的能力是生物医学中机器学习的一个关键挑战。虽然 GPT-3 表现出一些外推行为 ( 例如,生成以前从未见过的新文本 ) ,但其机制尚不清楚,仍处于起步阶段。需要进一步的研究来提高基础模型的外推能力,特别是在考虑医疗保健和生物医学固有的各种数据模式和任务时,但在当前的 GPT-3 和相关模型中通常不研究。

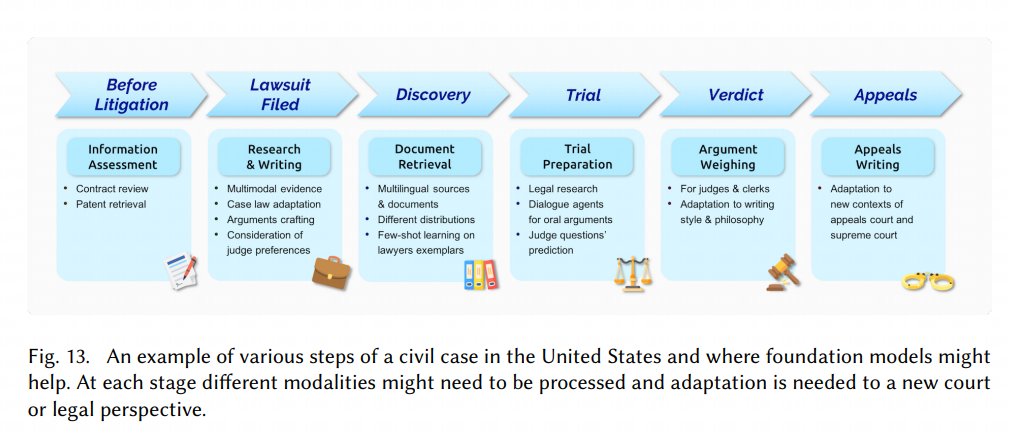

法律

机会

大模型独一无二的优势:

有限注释学习。

注释的成本数据非常高。通常,制作高质量标签的专业知识只能在律师身上找到,他们每小时收费数百美元。即使在获得标签之后,某些数据也可能是错误的,敏感的,不能汇集在一起训练一个大的语言模型。鉴于最近的进展在 few-shot 学习中,基础模型是最有前途的路径之一用于具有有限注释的学习模型。

大量历史数据。

法律决策需要不同尺度的背景:所有历史知识判决和标准,判例法的知识,仍然适用于目前,和了解手头个案的细微差别。基础模型是有可能学习历史和法律背景的共同表征为个别情况建模的语言能力和精度。

挑战与风险

长文本的叙述。

通常美国法庭使用的陈述文件长度在 4,700 字到 15,000 字之间。一个案件回溯文件通常达到 20,000 到 30,000 字。目前大模型对于长文本的生成无法达到这个长度。

检索,概念漂移,论点形成和逻辑推理。

目前大模型对于论点的逻辑推理部分能力较弱。

准确度。

基础模型在这个过程中制造虚假事实,这是一个已经存在的问题出现在当前的模型中。特异性和真实性是两回事,在法律环境中尤为重要,不精确的陈述可能会导致激烈的、意想不到的后果和虚假陈述可能导致对律师的制裁。

适应性。

不同的法律任务可能需要不同的训练过程,自适应目前较差。

教育

机会

挑战与风险

判断学生的作业是否是由 AI 生成的。

VSCode 推出了 CoPilot,这使得编程初学者的体检受到影响。

隐私和安全

在美国,学生信息尤其是 13 岁一下的儿童尤其重要。FERPA 限制了教师分享学生作业,这可能直接影响用于培训和评估基础模型的数据的主动性。包括基础模型的权重是否会以某种方式泄露数据。

贡献者

更新日志

941fa-feat(theme): upgrade and use collections于eb6eb-improve(docs): use pangu formatter于44c43-improve(docs): use svg picture于af478-improve(docs): use chinese punctuation于ed3ef-improve(docs): add tags and fix text typo于25255-fix(docs): text typo于fea7c-improve(docs): delete extra whitespace and blank lines于c1c02-modify(docs): remanage folders and rename files于0d7d2-docs: update docs于90e37-docs: update docs于